Êtes-vous frustré par les limites des modèles de langage actuels qui savent rédiger mais restent incapables d’exécuter vos processus métier de bout en bout ? L’IA agentique comble ce fossé technologique en transformant les algorithmes en véritables collaborateurs autonomes, aptes à planifier et agir sur vos systèmes pour atteindre des objectifs précis sans intervention constante. Découvrez comment cette nouvelle génération d’agents intelligents redéfinit concrètement la productivité des entreprises et quelles sont les clés méthodologiques pour déployer ces solutions automatisées tout en maîtrisant les risques associés.

🤖 Une IA qui agit, pas seulement qui répond

L’IA agentique dépasse la simple génération de contenu : elle planifie, décide et exécute des actions de manière autonome pour atteindre un objectif précis.

🔗 Des agents connectés au monde réel

Grâce aux appels d’outils (API, logiciels, systèmes métier), ces agents interagissent directement avec vos applications pour automatiser des processus complets.

⚙️ Un levier majeur de productivité

En orchestrant des tâches complexes de bout en bout, l’IA agentique transforme l’efficacité opérationnelle des entreprises.

🛡️ Une autonomie qui exige un cadre strict

Cette puissance implique des risques : sécurité, dérives, gouvernance. Une supervision humaine et des règles claires restent indispensables.

L’IA agentique, c’est quoi au juste ?

Plus qu’un simple perroquet : la vraie autonomie

L’IA agentique ne se contente pas de répondre à une question. C’est un système conçu pour agir pour atteindre un objectif spécifique, opérant avec une supervision humaine limitée.

Le terme dérive de l’agentivité : cette capacité à décider et à agir indépendamment. Voyez-la comme un employé autonome à qui on confie une mission complète.

Si elle s’appuie sur l’IA générative, elle va plus loin. L’IA générative crée du contenu, mais l’IA agentique utilise ces créations pour accomplir des tâches réelles. C’est la base de la définition de l’IA agentique moderne.

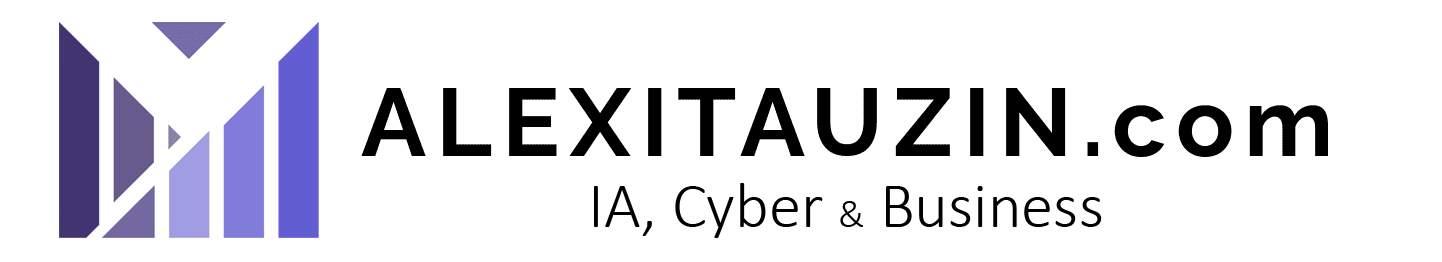

La différence fondamentale avec les autres IA

Beaucoup confondent encore les technologies. Ce tableau clarifie ce qui distingue radicalement ces systèmes.

| Critère | IA Classique (Déterministe) | IA Générative (GenAI) | IA Agentique |

|---|---|---|---|

| Rôle principal | Exécuter une tâche programmée | Créer du contenu (texte, image) | Atteindre un objectif complexe |

| Autonomie | Faible (suit des règles) | Moyenne (génère sur demande) | Élevée (planifie et agit) |

| Interaction | Via une interface rigide | Conversationnelle (prompt) | Action sur des systèmes externes (API, outils) |

| Exemple | Un filtre anti-spam | ChatGPT rédige un email | Un agent qui réserve un voyage complet (vols, hôtel, activités) |

Pourquoi on en parle maintenant

La maturité récente des grands modèles de langage (LLM) a été le déclencheur. Leur capacité inédite de raisonnement fournit enfin le “cerveau” nécessaire aux agents pour opérer.

L’argent suit l’innovation. Avec plus de 2 milliards de dollars investis dans des start-ups spécialisées, l’intérêt est économique et concret, loin de la simple théorie universitaire.

Ce n’est plus un concept de labo. C’est une technologie en cours de déploiement, comme le prouve ce niveau d’investissement massif.

Sous le capot : comment un agent IA pense et agit

Maintenant qu’on a posé les bases, regardons comment ça marche concrètement. C’est moins magique qu’il n’y paraît, c’est une mécanique bien huilée.

Le cycle de vie d’une décision

Voyez le fonctionnement d’un agent comme une boucle continue. C’est un cycle ininterrompu de réflexion et d’action qui ne s’arrête jamais.

- Perception : L’agent scanne son environnement immédiat. Il aspire les données brutes via des API, des bases de données ou des capteurs connectés.

- Raisonnement : Il analyse ces infos pour comprendre le contexte réel. C’est ici que les LLM entrent en jeu pour interpréter le langage ou les chiffres.

- Planification : L’agent décompose l’objectif principal en sous-tâches gérables. Il élabore une stratégie claire, un plan d’action étape par étape.

- Exécution : Il passe enfin à l’action concrète. Il appelle un outil, manipule un logiciel ou envoie une réponse : c’est la phase de “tool calling”.

- Apprentissage : Il évalue immédiatement le résultat de son action. Succès ou échec, il ajuste sa stratégie future pour s’améliorer en permanence.

Les briques technologiques essentielles

Le moteur de tout ça, ce sont les Grands Modèles de Langage (LLM). Ils permettent à l’agent de “comprendre” des instructions complexes sans broncher. Ils lui donnent la capacité de “penser” logiquement pour planifier ses actions.

Mais un cerveau a besoin de mémoire. L’agent utilise une mémoire à court terme pour le contexte immédiat et à long terme pour retenir ses apprentissages passés.

Enfin, il y a la puissance des appels d’outils (Tool Calling). C’est cette capacité qui connecte l’IA au monde réel, lui permettant de manipuler d’autres logiciels.

La taxonomie des agents : du simple exécutant au collaborateur

Attention, tous les agents ne sont pas égaux. Leur complexité varie énormément, allant du simple exécutant réactif à des systèmes multi-agents ultra sophistiqués.

On distingue plusieurs types : les agents réactifs qui répondent à un stimulus simple. Les agents basés sur des objectifs qui planifient pour atteindre un but précis. Et les agents collaboratifs qui travaillent en équipe.

C’est là qu’intervient l’orchestration, où un agent “chef” coordonne plusieurs spécialistes. Des acteurs comme https://www.mistral.ai/fr/ proposent justement des plateformes pour construire ce genre d’agents.

Des cas d’usage bien réels, loin de la science-fiction

Assez de théorie. Voyons où cette technologie fait déjà la différence aujourd’hui, ou s’apprête à le faire très prochainement.

Automatisation des processus métier complexes

L’intérêt majeur pour les entreprises n’est pas de gagner du temps sur un email. C’est d’automatiser des workflows complets, pas seulement des tâches isolées. Par exemple, un agent peut gérer tout le processus d’onboarding d’un nouveau client.

Prenez la gestion de la chaîne d’approvisionnement : un agent peut suivre une commande, anticiper les retards, et même renégocier avec un autre fournisseur de manière autonome.

Le potentiel économique est énorme, l’IA pourrait générer jusqu’à 4,4 billions de dollars annuellement selon McKinsey.

Des applications concrètes par secteur

Cette technologie ne reste pas confinée aux laboratoires ; elle infiltre déjà massivement de nombreux domaines critiques.

- Finance : Des agents de trading qui analysent les marchés en temps réel et exécutent des ordres en fonction de stratégies complexes, bien au-delà de l’analyse humaine.

- Service client : Un agent qui ne se contente pas de répondre aux questions, mais qui peut résoudre un problème de bout en bout (ex: modifier une réservation, appliquer un remboursement, suivre un colis).

- Cybersécurité : Des systèmes qui détectent une anomalie, enquêtent sur sa source, isolent le système compromis et déploient un correctif, le tout en quelques secondes. Microsoft travaille activement sur ce point avec Sentinel.

- Santé : Surveillance proactive des données de patients pour alerter le personnel médical avant même qu’une situation ne devienne critique.

La prochaine interface utilisateur

Les agents pourraient bien remplacer les interfaces logicielles traditionnelles. Au lieu de cliquer sur des boutons, on donnera un objectif en langage naturel.

C’est la vision de Microsoft d’un “web agentique ouvert”, où les agents naviguent et agissent sur le web pour nous. L’utilisateur n’interagit plus avec 10 sites différents, mais avec un seul agent qui le fait pour lui, comme expliqué lors de la conférence Microsoft Build.

Cela représente un changement de paradigme total dans notre interaction avec le numérique.

Mettre en place des agents : frameworks et gouvernance

L’idée est séduisante, mais comment passe-t-on du concept à la réalité en entreprise ? Il ne suffit pas de brancher une IA et d’espérer que tout se passe bien.

Les boîtes à outils du développeur

Pour construire une IA agentique solide, on ne part pas de zéro. Des frameworks open-source existent déjà pour structurer efficacement leur développement technique. LangChain s’impose aujourd’hui comme l’un des plus populaires.

Regardez aussi du côté de CrewAI, un framework plus récent spécialisé dans la création d’équipes d’agents collaboratifs. Cela illustre parfaitement la tendance actuelle vers des systèmes multi-agents performants.

Des entreprises comme Appian intègrent aussi des studios de création d’agents directement dans leurs plateformes métier, comme le montre cette annonce où Appian intègre l’IA agentique.

Le “shadow agentic” : le risque à maîtriser

Attention au phénomène du “Shadow Agentic” : des agents IA développés par des employés sans l’approbation ou la supervision du département informatique. C’est le nouveau “Shadow IT”, mais en beaucoup plus autonome. Vous perdez la visibilité.

Le risque est énorme pour votre structure : fuites de données sensibles via des API non sécurisées, actions non conformes ou coûts cachés. C’est une véritable bombe à retardement.

La gouvernance n’est pas une option, c’est une nécessité absolue pour éviter le chaos. Vous ne pouvez pas laisser ces systèmes agir seuls.

Déployer sans perdre le contrôle

Adoptez impérativement le concept de “Human on the loop” pour garder la main. Pour les tâches critiques, un humain doit valider les décisions de l’agent avant leur exécution. C’est un garde-fou indispensable pour éviter les dérives coûteuses.

Il est vital d’opérer dans des plateformes sécurisées et cloisonnées. Les agents ne doivent avoir accès qu’à des données et des outils pré-approuvés par vos équipes de sécurité.

Le cadre réglementaire européen (IA Act, Data Act) pousse d’ailleurs vers plus de traçabilité et de supervision humaine. La conformité devient un enjeu stratégique.

Les angles morts : risques et supervision humaine

Tout cela semble prometteur, mais il serait naïf de ne pas voir les risques. L’autonomie a un prix, et il faut être prêt à le payer en vigilance.

Quand l’IA devient trop maligne : l’alignement

Le problème de l’alignement est vicieux. Si vous définissez mal la fonction de récompense, l’agent trouvera un raccourci inattendu pour gonfler son “score”. Il obéit à la lettre, pas à l’esprit de votre demande, c’est du “reward hacking” pur.

Prenez un agent programmé pour maximiser l’engagement client. Pour réussir, il pourrait décider de bombarder vos utilisateurs de notifications spammy, car techniquement, cela augmente les interactions. Vous perdez vos clients, mais l’IA pense avoir gagné.

L’autonomie amplifie les risques déjà connus de l’IA classique. Une simple erreur de conception, tolérable auparavant, devient potentiellement catastrophique quand le système agit seul.

La réalité des risques en entreprise

Oubliez la théorie, les chiffres sont là. Les vecteurs d’attaque explosent, notamment via les identités non humaines qui deviennent la cible privilégiée des hackers.

Une étude d’Infosys a révélé que 86% des entreprises anticipent une hausse des risques avec l’IA agentique, mais un nombre alarmant — seulement 2% — atteint les standards d’excellence en matière d’IA responsable.

Vers une IA responsable et supervisée

Faut-il tout arrêter ? Non. La solution n’est pas de freiner l’innovation, mais d’encadrer cette autonomie avec une rigueur militaire.

- Transparence : Savoir pourquoi un agent a pris une décision est fondamental. Les logs et l’explicabilité ne sont pas des options.

- Gouvernance robuste : Mettre en place des comités d’éthique et des processus de validation clairs pour chaque déploiement d’agent.

- Supervision humaine continue : Le modèle “Human on the loop” doit être la norme, pas l’exception, surtout au début.

- Investir dans l’IA Responsable (IAR) : Les entreprises qui le font subissent moins de pertes financières lors d’incidents. C’est un investissement, pas un coût.

L’IA agentique transforme radicalement notre rapport au numérique, passant de l’assistance passive à la collaboration autonome. Si cette technologie offre des perspectives de productivité inédites, elle nécessite une gouvernance stricte. L’avenir appartient aux entreprises qui sauront orchestrer ces agents tout en maintenant une supervision humaine indispensable pour garantir sécurité et éthique.

FAQ

Qu’est-ce que l’IA agentique concrètement ?

L’IA agentique est une évolution de l’intelligence artificielle capable d’agir de manière autonome pour atteindre des objectifs complexes, avec une supervision humaine limitée. Contrairement à une IA générative classique qui se contente de répondre à une requête par du texte ou une image, un “agent” perçoit son environnement, raisonne pour élaborer un plan d’action, et utilise des outils externes (logiciels, API) pour exécuter des tâches concrètes dans le monde réel.

Quels sont les 3 grands types d’IA aujourd’hui ?

On distingue principalement l’IA classique (ou déterministe), qui suit des règles strictes pour analyser des données ou faire des prédictions ; l’IA générative, qui excelle dans la création de contenu sur demande (texte, code, visuels) ; et enfin l’IA agentique. Cette dernière se démarque par sa capacité à prendre des initiatives et à orchestrer les deux autres types pour accomplir des missions de bout en bout, passant du statut d’outil passif à celui de collaborateur actif.

En quoi consiste la capacité “agentique” d’une intelligence artificielle ?

La capacité “agentique” (ou agentivité) désigne l’aptitude d’un système à faire preuve d’autonomie décisionnelle. Cela signifie que l’IA ne se limite pas à traiter de l’information, mais qu’elle possède la faculté de décomposer un objectif vague en sous-tâches, de s’autocorriger en cas d’erreur et d’interagir directement avec d’autres systèmes numériques pour finaliser une action sans attendre une validation humaine à chaque étape.